Die neue KI-Ära im industriellen Service mit AI Agenten und Agentic Web

Künstliche Intelligenz entwickelt sich seit Jahrzehnten kontinuierlich weiter. Von den symbolischen KI-Experimenten der Anfangszeit über die Ära der generativen KI wie ChatGPT bis hin zur jüngsten Entwicklung: den AI Agenten.

Warum AI Agenten die logische nächste Stufe sind

AI Agenten heben Künstliche Intelligenz auf ein neues Level, weil sie eigenständig und zielgerichtet Aufgaben lösen können. Sie bestehen im Kern aus zwei entscheidenden Elementen:

- Einem großen Sprachmodell, das Gedankenprozesse von Interpretation bis Argumentation simuliert.

- Einer Toolbox mit spezifischen, abrufbaren Funktionen wie Datenbankzugriffen oder Berechnungsmodulen.

Im Gegensatz zu herkömmlichen Large Language Models (LLMs), die einmalig auf Anfragen antworten, durchlaufen AI Agenten iterative Prozesse. Sie geben strukturierte Anweisungen aus, interagieren mit Werkzeugen, sammeln Ergebnisse und verbessern ihre Antworten schrittweise, bis sie eine finale Lösung liefern können.

Vom Assistenten zum autonomen Kollegen

Mit wachsender Autonomie verändert sich die Rolle der Mitarbeitenden im industriellen Service schrittweise:

- Agenten unterstützen Menschen, während Menschen die Kontrolle behalten und Agenten für Informationsbeschaffung und erste Analysen nutzen.

- Menschen und Agenten kooperieren zusammen. Agenten schlagen Aktionen vor, Mitarbeitende prüfen und verfeinern diese Vorschläge.

- Agenten operieren, Menschen überwachen. Agenten übernehmen komplette Aufgaben, während Menschen Ergebnisse kontrollieren und nur in Grenzfällen eingreifen.

Agentic Web – Infrastruktur für intelligente Interaktionen

Diese dynamische Zusammenarbeit von Agenten, Menschen und Unternehmenssystemen erfordert eine flexible und offene Infrastruktur, bekannt als das Agentic Web. Dieses Netzwerk erlaubt es verschiedenen Agenten nahtlos miteinander und mit den Fachleuten sowie den bestehenden Systemen eines Unternehmens zu kommunizieren.

Zukunftssicher durch offene Standards

Damit das Agentic Web effizient und skalierbar funktionieren kann, sind offene und universelle Standards entscheidend. Zwei dieser Standards gewinnen besonders an Bedeutung:

Model Context Protocol (MCP)

MCP dient als universelle Schnittstelle, vergleichbar mit http im Internetkontext. Die Agenten greifen auf die MCP Server, die s genannte Funktionskataloge sind, zu und können Daten flexibel abrufen. Es reduziert Komplexität, da spezialisierte Software direkt über natürliche Sprache gesteuert und die Integration von vielfältigen Datenquellen vereinfacht wird.

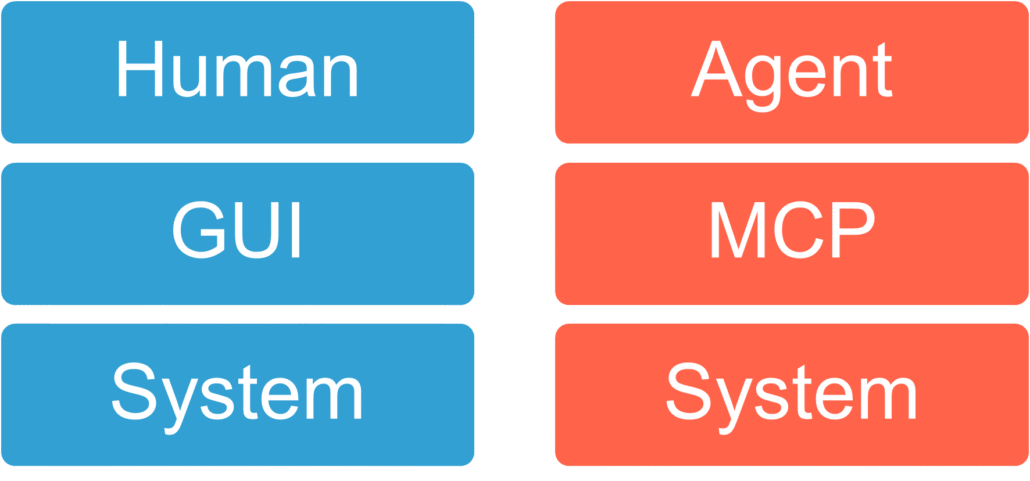

MCP kann für Agenten als das betrachtet werden, was GUIs für Menschen sind. Sie ermöglichen es dem Agenten, sich mit zugrunde liegenden Funktionen wie Systemintegrationen zu verbinden und mit ihnen zu arbeiten.

Agent2Agent (A2A)

A2A standardisiert den Ablauf, wie Agenten untereinander und mit Menschen kommunizieren, Aufgaben übergeben und den Fortschritt transparent verfolgen können. Durch klar definierte Schnittstellen schafft A2A eine Grundlage für effiziente Zusammenarbeit zwischen autonomen Systemen und menschlichen Mitarbeitenden.

Bild von Agent2Agent Protocol (A2A)

Warum Serviceorganisationen jetzt handeln sollten

Die Integration von AI Agenten und der Aufbau eines Agentic Webs sind keine Zukunftsmusik mehr, sondern bereits Realität. Allerdings muss dieser Übergang nicht abrupt erfolgen. Mit der Einführung einer Assistenten-Plattform geschieht der Wandel schrittweise und im Tempo, mit dem sich Unternehmen, Mitarbeitende und Kunden gleichermaßen wohlfühlen. Der berüchtigte „Big Bang“ wird vermieden. Serviceorganisationen, die sich frühzeitig mit diesen Technologien auseinandersetzen und offene Standards wie MCP und A2A implementieren, sichern sich langfristig Wettbewerbsvorteile. Sie legen damit den Grundstein für eine intelligente, agile und zukunftssichere Infrastruktur im industriellen Service.

Startseite »