AI-Agenten und Agentic AI im Kundenservice verstehen und nutzen

Stell dir vor, 80 Prozent aller Kundenanfragen in deinem Service-Center werden bis zum Ende des Jahrzehnts vollständig autonom gelöst. Und das bei bis zu 30 Prozent geringeren Betriebskosten. Diese Prognose stammt von Gartner und beschreibt die Entwicklung, die durch Agentic AI möglich wird. Erste Marktbeispiele belegen diese Richtung, doch der eigentliche Vorsprung entsteht nicht bei den großen Plattformanbietern, sondern bei Lösungen, die flexibel genug sind, sich nahtlos an deine Prozesse anzupassen.

Einordnung von AI-Agenten und Agentic AI

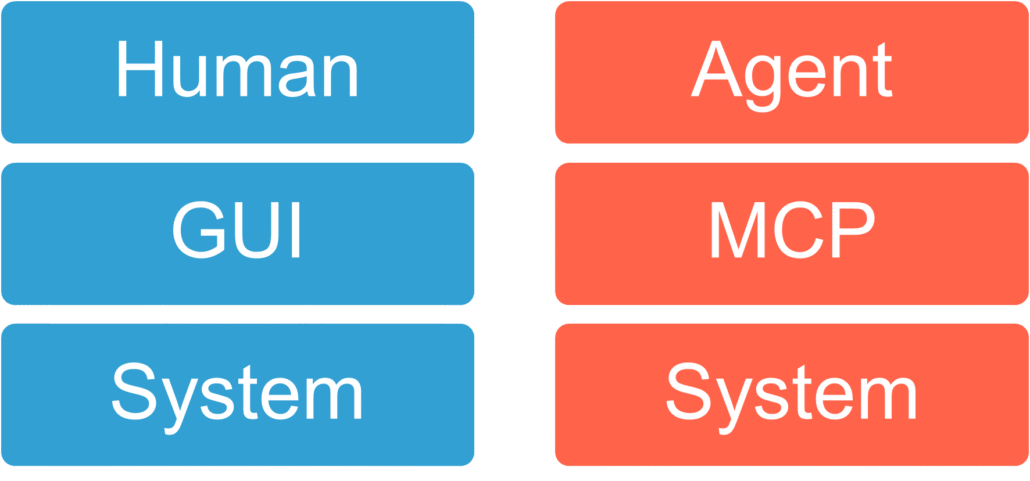

AI-Agenten sind autonome Software-Systeme, die ihre Umwelt wahrnehmen, Entscheidungen treffen und durch maschinelles Lernen ihre Leistung kontinuierlich verbessern. Damit unterscheiden sie sich klar von klassischen Chatbots, die nur vordefinierte Antworten liefern.

Agentic AI geht einen Schritt weiter. Diese Systeme handeln proaktiv, verfolgen eigenständig Ziele, planen mehrstufige Prozesse und passen ihr Verhalten flexibel an neue Kontexte an. Damit entwickelt sich Agentic AI zu einem intelligenten Kollegen, der nicht nur unterstützt, sondern Entscheidungen vorbereitet und teilweise ersetzt.

Welchen Nutzen AI-Agenten und Agentic AI deinem Service bringen

Der Einsatz von Agentic AI im Kundenservice eröffnet enorme Potenziale. Contact Center können ihre Betriebskosten deutlich senken und gleichzeitig die Abschlussrate steigern, ohne dafür nach dringend benötigten Fachkräften zu suchen. Routineaufgaben wie Dokumentation, Ersatzteilmanagement oder Standardanfragen übernimmt die KI, während dein Team sich stärker auf komplexe Fälle konzentriert.

Für deine Kunden bedeutet das ein völlig neues Erlebnis: Sie erhalten proaktive, kontextbewusste Antworten, die Bedürfnisse oft schon im Vorfeld erkennen und bedienen. Außerdem ist es längst Realität, dass bereits heute Agentic-Systeme bis zu 15 Prozent alltäglicher Entscheidungen zuverlässig übernehmen.

Wohin sich AI-Agenten und Agentic AI bis 2030 entwickeln werden

Die Entwicklung zeigt klar in die Richtung einer Agent-Economy. Intelligente Agenten werden zu festen Bestandteilen von Wertschöpfungsketten, arbeiten zusammen und optimieren Prozesse in Echtzeit. Marktbeispiele wie Salesforce unterstreichen zwar, dass hohe Automatisierungsquoten erreichbar sind. Doch sie belegen vor allem, dass Agentic AI keine Zukunftsvision, sondern bereits Realität ist.

Der Unterschied liegt darin, wie du diese Realität gestaltest. Während große Anbieter oft Standardwege vorgeben, wird sich bis 2030 ein hybrides Modell durchsetzen, in dem Agentic AI Routinefälle souverän bearbeitet und dein Team als empathischer Partner Nähe und Vertrauen schafft. Gleichzeitig wächst die Bedeutung von Governance und Transparenz. Da nur wenige Führungskräfte Agentic AI wirklich verstehen, werden klare Audit-Prozesse und Ethik-Leitlinien unverzichtbar.

Warum targenio dir schon heute mehr Möglichkeiten bietet

Viele glauben, dass Agentic AI noch Zukunftsmusik ist. Mit den richtigen Werkzeugen kannst du jedoch sofort starten. Genau hier liegt der Vorteil der targenio Assistenten-Plattform. Sie erlaubt es dir, AI-Agenten direkt in deine Serviceprozesse zu integrieren. Flexibel, transparent und so individuell, wie dein Unternehmen es braucht. Standardanfragen werden automatisiert bearbeitet, Prozesse durchgängig dokumentiert und komplexere Fälle intelligent an dein Team eskaliert. Dabei übernehmen die Assistenten auch in diesen Fällen Routineaufgaben – wie Recherche, Vorbefüllung oder Dokumentation – und entlasten so deine Experten, die sich auf die wirklich entscheidenden Schritte konzentrieren können.

Darüber hinaus lässt sich die targenio Assistenten-Plattform problemlos an Salesforce und andere Systeme anbinden. Das bedeutet, du musst nicht zwischen Plattformen wählen, sondern kannst bestehende Infrastrukturen nutzen und gleichzeitig den Schritt in die Agentic-AI-Welt gehen.

Damit bist du nicht auf die starren Vorgaben großer Anbieter angewiesen, sondern kombinierst deren Reichweite mit der Flexibilität und Innovationskraft von targenio. So entsteht ein hybrides Service-Ökosystem, das Effizienz, Transparenz und Menschlichkeit vereint.

KI-generiert

KI-generiert